康奈尔大学开发新型系统RHyME 使机器人通过观看教学视频学习

据外媒报道,康奈尔大学(Cornell University)的研究人员开发出一套名为RHyME(不匹配执行下的混合模仿检索)的人工智能(AI)赋能机器人框架,可以让机器人仅通过观看单个教学视频就学会执行任务。

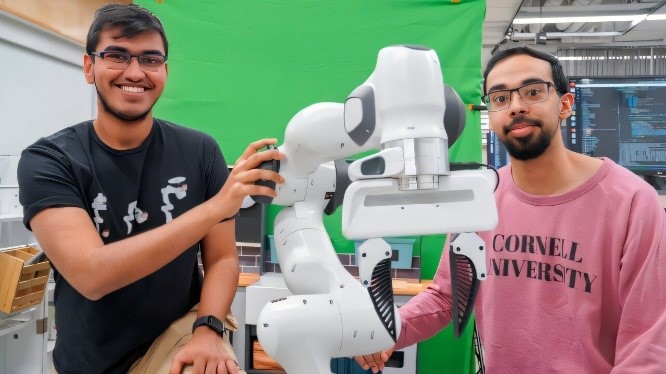

图片来源:Cornell University

机器人的学习过程通常较为苛刻——传统上需要精确的逐步指导才能完成基本任务,一旦出现计划外状况(如掉落工具或丢失螺丝)就会停止工作。研究人员表示,RHyME系统通过大幅减少训练所需的时间、精力和资金,有望加速机器人系统的开发和部署。

计算机科学博士生Kushal Kedia表示:“与机器人工作的烦人之处在于需要收集机器人执行不同任务时的大量数据。这完全不同于人类的学习方式——我们通过观察他人获得启发。”Kedia将在2025 IEEE机器人与自动化国际会议上发表题为《不匹配执行下的单次模仿学习》(One-Shot Imitation under Mismatched Execution)的论文,相关研究已发布于arXiv预印本服务器。

家用机器人助手距离实用仍有很长的路要走,因为它们缺乏在物理世界及其无数突发状况中灵活应对的智能。为了让机器人快速掌握技能,像Kedia这样的研究人员正在用教学视频的内容训练它们——即在实验室环境中录制人类演示各种任务的过程。这种被称为“模仿学习”的机器学习分支方法,其核心目标是让机器人能更快掌握一系列任务,并具备适应现实环境的能力。

资深作者、计算机科学助理教授Sanjhiba Choudhury解释道:“我们的工作就像把法语翻译成英语——将人类任务翻译为机器人指令。但这项翻译任务面临着更大的挑战:人类的动作过于流畅导致机器人难以追踪和模仿,且视频训练需要海量数据。研究人员指出,演示视频(如拾取餐巾或叠放餐盘)必须缓慢完美地执行,因为视频中的动作与机器人的动作存在任何不匹配都会导致学习失败。”

Choudhury表示:“如果人类的移动方式与机器人的移动方式有任何不同,这种方法就会立即失效。我们的想法是:我们能否找到一种原则性的方法,来处理人类和机器人在执行任务时的这种不匹配?”

RHyME就是该研究团队给出的解决方案——这是一种可扩展的方法,能够降低机器人的操作敏感性并增强其适应能力。该系统通过强化机器人调用自身记忆的能力,使其在仅观看一次任务演示后,就能结合过往观看的视频资料建立任务执行的关联逻辑。具体而言,当装备RHyME系统的机器人观看人类从台面取杯子放入水槽的演示视频时,它会自动检索视频数据库,并从类似操作动作(例如抓握杯具、放下餐具等)中提取可借鉴的执行策略。

研究人员表示,RHyME为机器人学习多步骤任务序列铺平了道路,同时显著降低了训练所需的机器人数据量。RHyME仅需30分钟的机器人训练数据;在实验室环境下,使用该系统训练的机器人与传统方法相比,任务成功率提升了50%以上。

Choudhury表示:“这项工作彻底改变了当前机器人编程的方式。现有的机器人编程需要数千小时的远程操作来教会机器人执行任务,而这根本不可行。有了RHyME,我们正在突破这种限制,以更具可扩展性的方式训练机器人。”

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。