破局端侧模型更新难题!艾拉比差分算法获国际学界认可

近日,端侧大模型迭代升级最新研究成果公布:艾拉比智能科技研发的端侧大模型差分升级算法ResComp成功被环太平洋人工智能国际会议(PRICAI) 录用,标志着该技术在轻量化部署与高效更新方面获得全球学术界的认可。这一突破不仅为端侧大模型的持续迭代提供了关键技术支持,更为AI在终端设备中的大规模迭代应用按下“加速键”。

端侧大模型进入高频迭代阶段,升级瓶颈亟待突破

随着大模型应用场景不断拓展,从云端走向终端已成为明确趋势。尤其是在汽车行业,端侧大模型凭借其低延迟、高隐私性及离线可用等优势,正迅速落地于辅助驾驶、智能座舱等核心场景,覆盖车内交互、运营优化与私有化模型定制等多个领域。

然而,模型迭代与升级的问题也随之浮现。传统OTA升级方式在面对动辄数GB甚至更大的模型文件时,显得力不从心。由于大模型参数结构复杂、数据极度压缩(量化),单纯依赖整体压缩传输效率极低,差分升级成为在有限的端侧资源下实现高效升级的优解。

而传统差分算法在端侧大模型更新实践中体现出三大短板,论文指出,传统增量编码算法因未适配LLM参数数据的特殊结构,在生成模型补丁时面临“压缩率低、更新速度慢、内存占用高”三大难题,严重制约端设备AI的体验升级与功能迭代。

艾拉比提出端侧大模型专项差分算法ResComp,实测表现卓越

面对这一行业瓶颈,提出了一种基于残差的差分算法ResComp。

ResComp算法以“结构对齐 残差优化”重构端侧LLM更新逻辑,实现三大核心技术突破:

其一,打破传统算法“离散匹配”的底层假设,直接对齐新旧模型的权重结构,精准捕捉参数变化规律,从源头降低冗余数据量。

其二,引入残差序列计算机制,配合bzip3压缩器形成“结构优化 高效压缩”的双重增益。

其三,创新加入游程编码(RLE)增强机制,实际部署时打补丁速度再提升30%。

实测表现卓越,差分包体积降至开源算法22%以下

为验证技术可靠性,团队在多个主流开放权重的LLM,以及Stable Diffusion系的图像生成模型上开展多场景测试。结果显示,无论是文本理解类LLM还是多模态模型,ResComp算法均能稳定实现“更小补丁体积、更低内存占用、更快更新速度”的综合优势。

与某开源算法相比,艾拉比的ResComp技术通过智能化的差分算法框架,能够精准识别大模型版本间的差异,生成极小的差分包,还显著缩短了升级时间,为行业带来了全新的解决方案。(开源信息见文末)

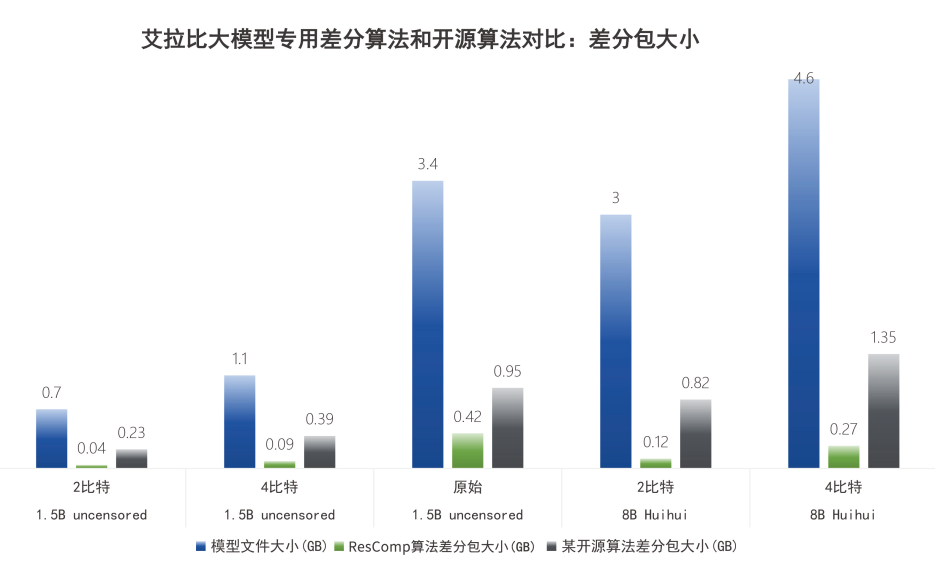

我们选取市面最热门的模型,通过比较在原始浮点格式和量化格式下的文件大小和差分压缩效果,将某开源差分算法和艾拉比ResComp进行比较,得到如下结果:

差分包大小:以DeepSeek的1.5B 4比特模型为例,ResComp生成的差分包仅为90MB,而开源算法需要400MB,艾拉比差分包大小仅为原包的5.7%,是开源算法差分包的22.5%。对于8B 4比特模型,ResComp的差分包大小为0.27GB,而开源算法需要1.35GB,艾拉比差分包大小为原包的5.2%,是开源算法差分包的19.9%。

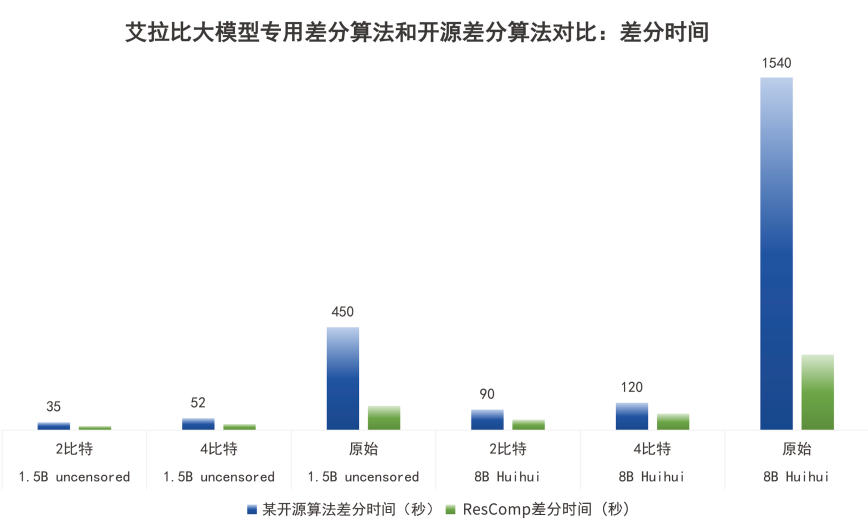

差分时间:以DeepSeek的1.5B 4比特模型为例,ResComp的升级时间为开源算法的50%。8B 2比特模型的升级时间是开源算法的51%。

(1.5B uncensored即 thirdeyeai/DeepSeek-R1-Distill-Qwen-1.5B-uncensored )

(8B Huihui即huihui-ai/DeepSeek-R1-Distill-Llama-8B-abliterated)

艾拉比此次的技术突破,不仅具备学术高度,更拥有广泛的产业应用前景。目前,该算法已完成技术转化,并集成进艾拉比差分升级标准化平台,逐步应用于公司智能终端AI解决方案、车载大模型升级平台等核心业务线。

尤其值得注意的是,在车联网场景下,端侧大模型差分升级不仅能显著降低流量成本,还可实现用户无感更新,避免因升级过程中断车内服务。即便在网络信号不稳定或无网环境下,仍能通过本地缓存与差分还原完成可靠升级。

随着边缘计算硬件性能持续提升和模型优化技术的进步,端侧大模型的应用广度与深度将不断扩展。而差分升级作为支撑模型持续演进的关键基础设施,其技术成熟度将直接影响AI应用的落地节奏与用户体验。

艾拉比ResComp算法的推出与落地,为行业提供了经过学术背书、实测有效的端侧模型升级方案,正推动端侧AI应用向“轻量化部署、高频次迭代”演进。

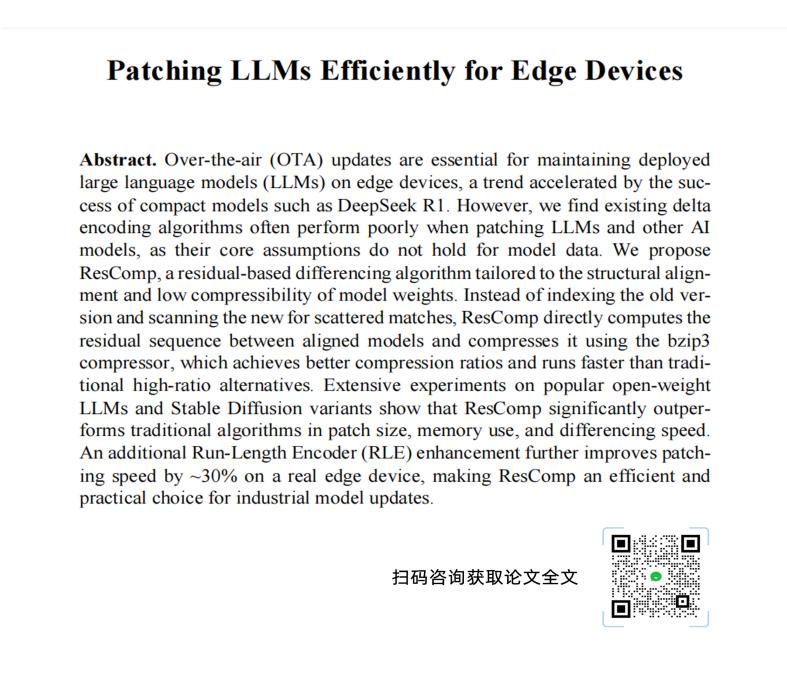

论文摘要信息:

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。