具身智能迎来“开悟时刻”

2025年岁末的具身智能赛道格外热闹。

12月18日,商汤旗下大晓机器人刚发布开悟世界模型3.0(Kairos 3.0);十日前,地平线机器人实验室展示了具身智能仿真数据引擎;而在更早的世界机器人大会上,宇树科技CEO王兴兴直言“模型问题比数据问题更关键”。

这些动态勾勒出行业共识:具身智能正从硬件竞赛转向“大脑”升级,而世界模型成为破局关键。

为何非得是世界模型?

如果说AI 1.0是人工标注的“慢时代”,AI 2.0是大语言模型的“快时代”,那么具身智能时代,就是数据缺口的“难时代”。

具身智能的本质,是让机器在物理世界中自主交互、解决复杂任务,而这一切的前提,是海量且高质量的数据支撑。但现实情况是,行业正面临着数据量级的断崖式缺口。

相较于智能驾驶汽车动辄百亿参数、近千TOPS算力的海量数据,仍处于量产初期的具身智能真机数据量级仅为10万小时,两者差距高达40倍。更遑论具身智能应用场景的多模态感知更丰富、执行动作更复杂、传感器数据更微观,其采集难度和成本远超此前的AI技术。

传统研发路径早已不堪重负。“以机器为中心”的研发范式中,数据采集堪称“烧钱烧力”的苦差事:一台机器人硬件成本动辄几十万,采集员需要全天候值守,通过真机遥操重复上千次相同动作,才能收集到一组可用数据。更致命的是,这样采集到的数据严重绑定于特定硬件——为A型号机械臂训练的抓取技能,无法直接应用到B型号上,“智能”被禁锢在单一躯壳之内,成为无法迁移的“专属技能”。

商汤科技联合创始人、执行董事、大晓机器人董事长在接受采访时,对此直言不讳:“这种路径本质是让人去适配机器,数据采集成本高、效率低,完全无法支撑行业向规模化、通用化发展。”

另一条被特斯拉、Figure AI寄予厚望的纯视觉学习路径,同样陷入困境。这种模式试图让机器人通过观看海量视频“模仿”人类动作,但缺乏对三维物理世界的底层认知——机器人能看到人“拿起杯子”,却无法理解杯子的重量、材质,以及“喝水”这一动作的核心意图。这种缺乏物理规律和因果逻辑的学习方式,存在难以逾越的“现实鸿沟”,机器人在视频中学会的动作,一旦放到真实场景中就容易“失灵”。

这两条路径的本质困境,前者是“为难人”,后者是“为难机器”,核心都在于未能理解人类与世界的交互规律。而世界模型的出现,正是为了填补这一空白。

具身智能不是简单让机器人“动起来”,而是要让它真正理解物理世界的规律,像人一样思考和行动。因此,对于具身智能而言,世界模型早已不是“选择题”,而是“必答题”。没有世界模型的支撑,机器人永远只是“执行指令的工具”;而有了世界模型,机器人才能真正拥有“理解世界的大脑”,从“被动响应”走向“主动探索”。

商汤打造世界模型的底层逻辑

作为深耕AI领域11年的企业,商汤科技对于AI有着独特的理解,更对于技术体系的搭建有着执着地尽善尽美地执着。

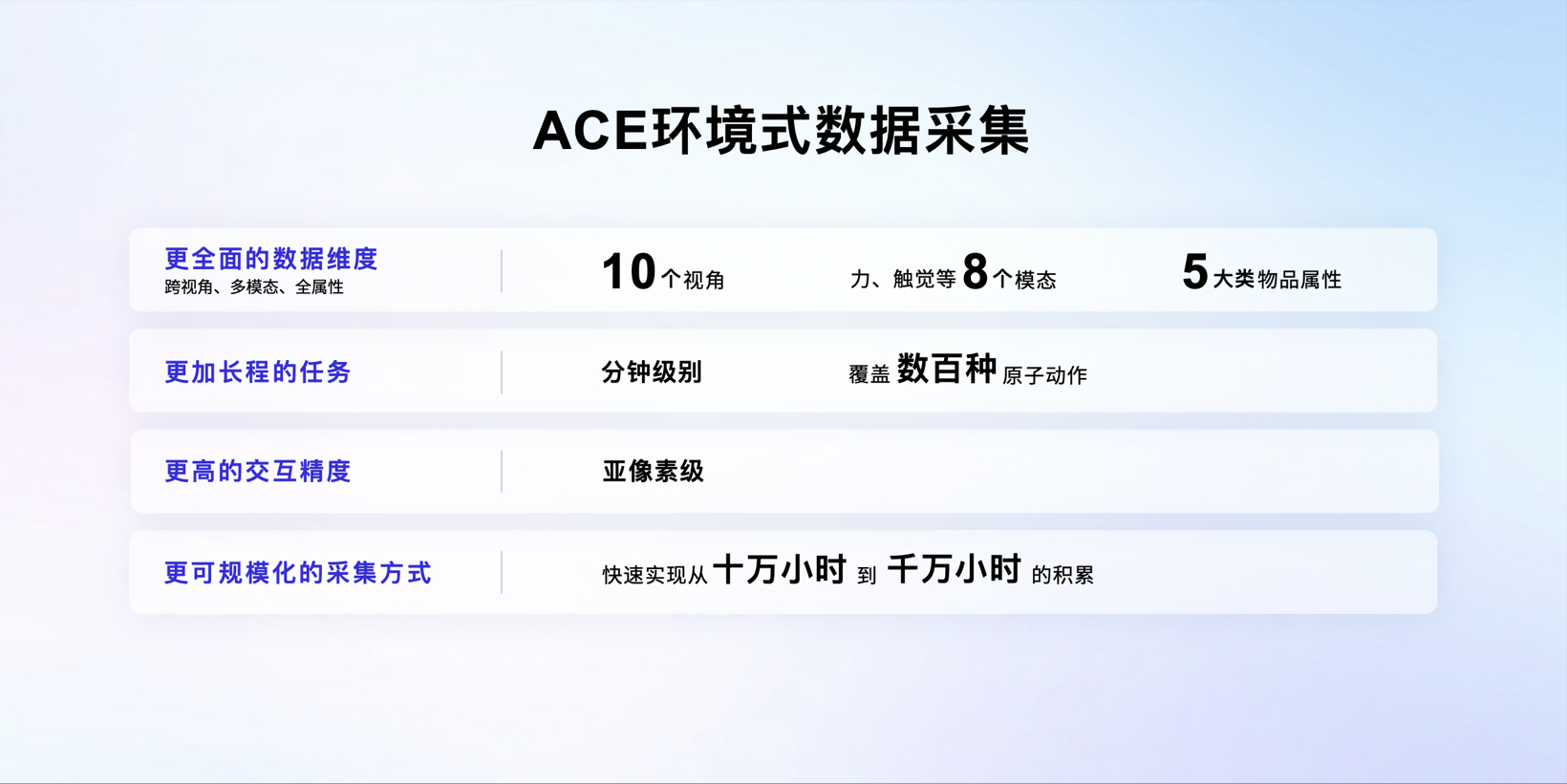

大晓机器人的第一步便是提出“以人为中心(Human-centric)”的ACE具身研发范式,构建了一套从“环境式数据采集—开悟世界模型3.0—具身交互”的全链路技术体系。

图片来源: 大晓机器人

以第一视角数据 第三视角的采集方式,构建了一套“以人为中心”的高效、高质的数据采集模式,实现了四大突破:数据维度覆盖超10个视角、8种模态、4大类物品属性,让机器人“看得到、摸得着、听得懂”;任务覆盖时长达到分钟级,能支撑数百种原子动作的复杂任务,比如从“打开冰箱—取出饮料—拧开瓶盖—递到手中”的全流程;交互精度达到亚像素级,可精准追踪人手抓取鸡蛋、摆放餐具等精细化操作;采集效率实现规模化,能快速完成从十万小时到千万小时的海量数据积累。

图片来源: 大晓机器人

在数据处理环节,商汤通过时序一致性对齐、交互动态轨迹预测建模与物理正确性仿真校正三大技术,将采集到的“人—物—场”原始数据,转化为可直接用于模型训练的动态场景数据。

图片来源: 大晓机器人

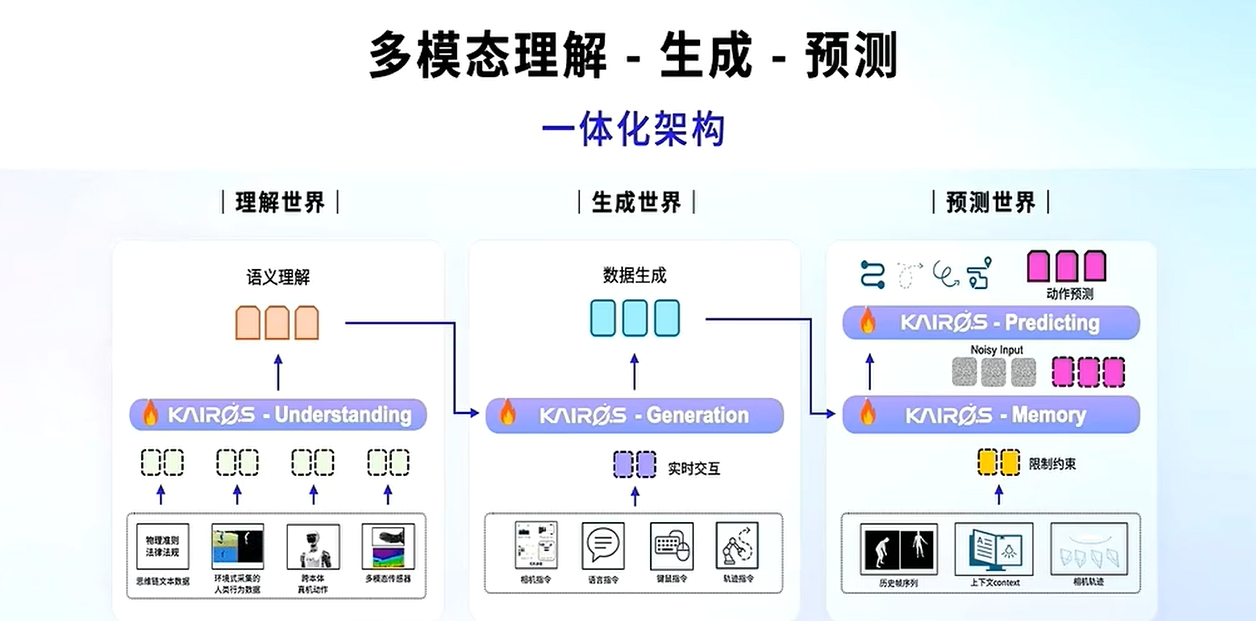

在这一研发范式中环境式数据采集可实现一年千万小时的数据收集,而开悟世界模型3.0则承担起“大脑”的角色,通过融合物理规律、人类行为和真机动作,让机器不仅能理解世界,还能生成长时动静态交互场景,预测不同动作的可能结果。

全产业链的生态协同,让商汤的技术优势进一步放大。在芯片领域,开悟世界模型3.0已与沐曦股份、壁仞科技、中科曙光、辉曦智能、影微创新等多款国产芯片完成适配,不仅极大提升了芯片性能,更构建了“模型—芯片”的协同生态。

“以前国产芯片适配模型难,因为模型不开源、芯片架构不透明,双方沟通成本极高。现在我们开源模型,芯片厂商能直接基于模型优化算法,效率提升了数倍。”王晓刚如是说。

而与此同时,大晓机器人进一步推出具身超级大脑模组A1,并与行业伙伴共建具身智能创新生态,加速机器人商业化落地,推进具身智能产业价值。

基于大晓机器人团队领先的纯视觉无图端到端VLA模型优势,搭载具身超级大脑模组A1的机器狗无需预采高精地图即可适应复杂、动态、陌生环境。依托模型的视觉理解和运动规划能力,机器人能实现动态环境下鲁棒、安全、合理的路径生成,真正实现“自主行动”。

基于大晓机器人纯视觉无图端到端VLA模型优势,搭载具身超级大脑模组A1的机器狗无需预采高精地图即可适应复杂、动态、陌生环境。依托模型的视觉理解和运动规划能力,机器人能实现动态环境下鲁棒、安全、合理的路径生成,真正实现“自主行动”。

此外,大晓机器人结合Insta360全景感知方案与商汤方舟通用视觉平台,构建起全方位、高精度的环境感知体系。不仅能覆盖超10个行业,还可实现超150个智能化应用场景适配,覆盖从日常行为分析到特殊风险预警的全需求。“十年前,我们把静止的摄像头接入方舟平台;今天,我们把移动的机器人接入方舟平台,背后的应用痛点其实是相通的。”王晓刚说。

硬件领域,大晓机器人与Insta360、卧龙电驱、帕西尼等伙伴深度绑定,依托硬件厂商的感知等各类硬件,强化世界模型、模组产品对多视角、动态场景的信息采集能力。

图片来源: 大晓机器人

在云服务与数据层面,大晓机器人联合商汤大装置、腾讯云、火山引擎、商汤方舟、算丰信息等平台,构建全流程支持体系。借助云服务商的算力调度能力,降低中小厂商的研发成本;依托库帕思、中建西南院的数据资源,持续优化世界模型的场景泛化能力,让方案能快速适配不同行业的个性化需求。

现如今,在具身本体领域,大晓已携手智元机器人、银河通用、钛虎机器人、国地中心等多家头部企业,打通全新技术范式、世界模型与机器人硬件的适配链路,共同打造适用于不同场景的解决方案。而这种场景积累,让开悟世界模型3.0能快速适配不同行业需求。

这种“技术 场景 生态”的组合拳,让开悟世界模型3.0不仅是一款技术产品,更成为推动具身智能产业发展的核心引擎。

具身智能刚刚起步,开源破局

“今天世界模型只是一个起点。”在媒体沟通会上,王晓刚坦言,“我们自己能接触到的场景是有限的,只有让全球开发者参与进来,才能让世界模型覆盖更多垂类场景。”王晓刚坦言。”

而这也正是大晓机器人开源开悟世界模型3.0的核心逻辑。

在AI领域,开源与商业化的平衡始终是争议焦点,而商汤的选择,不仅需要技术自信,更需要对产业发展规律的深刻洞察。

开悟世界模型3.0的开源,首先破解了场景覆盖不足的行业痛点。具身智能的应用场景无限多样——从家庭服务到工业生产,从医疗护理到物流仓储,每个场景的需求都千差万别。单一企业无论实力多么雄厚,都无法穷尽所有场景的数据采集和模型优化。

为了降低开发者门槛,商汤同步推出了开悟具身智能世界模型产品平台。该平台集成了“文生世界、像驱世界、迹塑世界”等多模态生成能力,内置11大类、54细类,累计328个标签,覆盖115个垂类具身场景。

开发者只需上传一张图片、输入一句自然语言指令,就能快速生成可视化的任务模拟内容——比如输入“机器人分拣苹果”,平台就能自动生成包含苹果物理属性、分拣动作轨迹、环境交互逻辑的训练数据。更重要的是,开发者可以在平台上分享自己创作的数据和模型,形成“创作—分享—迭代”的良性循环。

在英伟达芯片主导AI训练的时代,模型适配无需过多顾虑——大多数模型在英伟达芯片上都能顺畅运行。但国产芯片面临着架构多样、生态不完善的问题,一款模型要适配多款国产芯片,需要投入大量的研发资源。“如果模型不开源,芯片厂商不知道模型的底层逻辑,优化起来就像‘盲人摸象’;如果模型开源了,芯片厂商能直接针对模型的运算需求优化硬件架构和算法,效率会大幅提升。”王晓刚解释道。

更重要的是,开源正在重塑具身智能产业的竞争格局。过去,行业竞争更多是“闭门造车”,企业各自积累数据、研发模型,形成技术壁垒。而开源让行业竞争从“单点技术比拼”转向“生态协同比拼”。

未来的竞争不是某一家企业的竞争,而是生态与生态的竞争。谁能构建更开放、更繁荣的生态,谁就能在具身智能时代占据主导地位。

从ACE范式重新定义数据采集,到世界模型重构机器认知,再到开源战略重塑产业生态,大晓机器人的一系列举措正在为行业注入新的活力。然而,真正的挑战才刚刚开始。如何将技术优势转化为商业价值,如何在不同场景中实现规模化落地,如何构建可持续的商业模式,这些都是产业需要共同面对的课题。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。