工程师开发更智能的人工智能 重新定义复杂系统的控制

据外媒报道,佛罗里达大西洋大学(Florida Atlantic University)工程与计算机科学学院的研究人员开发出一项新的人工智能突破,为管理依赖于多个不同权限级别决策者的复杂系统提供了一种更智能、更高效的方案。

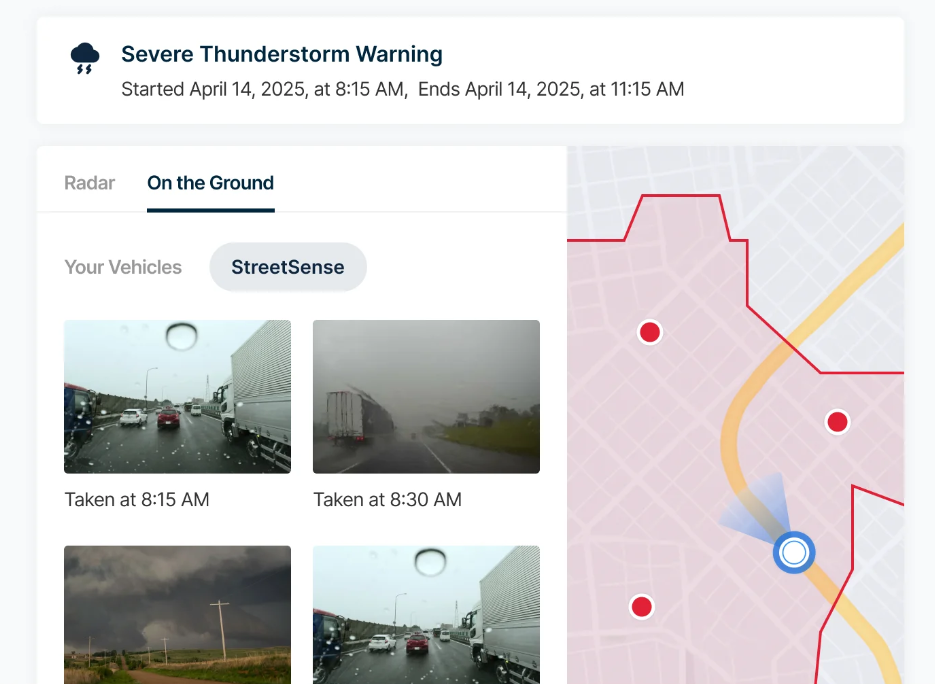

图片来源: 佛罗里达大西洋大学

相关研究论文已发表在期刊《IIEEE Transactions on Systems, Man and Cybernetics: Systems》上。这一新颖的框架可能会显著影响智能电网、交通网络和自动驾驶汽车系统的未来——这些技术正日益成为日常生活的核心。

在许多现实世界的系统中,决策并非同时或平等地发生。公用事业公司可能会决定何时在高峰时段断电,而家庭必须相应地调整能源使用。在交通系统中,中央控制器发出信号,车辆则进行相应调整。

“这类系统在权力等级制度下运行,其中一个参与者先行动,其他参与者必须跟进,而且它们比典型的人工智能模型假设的要复杂得多,”资深作者、电气工程与计算机科学系副教授Zhen Ni博士说道。“传统的人工智能方法通常将每个决策者视为平等,让他们同时行动,并拥有同等的影响力。虽然这可以实现清晰的模拟,但却无法反映现实世界中决策的真实情况——尤其是在充满不确定性、带宽有限且信息获取不均衡的环境中。”

为了解决这个问题,Ni和论文第一作者、电气工程与计算机科学系副教授Xiangnan Zhong博士设计了一个基于强化学习的全新人工智能框架。强化学习是一种允许智能体通过与环境的长期交互进行学习的技术。

该方法增加了两项关键创新。首先,它使用名为Stackelberg-Nash博弈的博弈论模型构建决策过程,其中“领导者”代理首先行动,“追随者”代理以最优方式响应。这种层级结构更好地反映了能源管理、互联交通和自动驾驶等系统。其次,研究人员引入了一种事件触发机制,从而减轻了计算负担。

“我们的方法并非像许多人工智能系统那样在每个时间步不断更新决策,而是仅在必要时更新决策,从而节省了能源和处理能力,同时保持了性能和稳定性,”Zhong说道。

最终,该系统不仅能够处理决策者之间的权力不对称,还能应对不匹配的不确定性——即不同参与者掌握的信息和可预测性程度各不相同的情况。这在智能电网或交通控制系统等环境瞬息万变且资源往往有限的环境中尤为重要。该框架能够实现更稳健、更具适应性且可扩展的人工智能控制形式,从而更好地利用有限的带宽和计算资源。

Zhong和Ni基于严谨的理论分析,并通过仿真研究验证,证明了他们的事件触发强化学习方法能够保持系统稳定性,确保最优策略结果,并有效减少不必要的计算。该方法将深度控制理论与实用机器学习相结合,为非对称、不确定环境下的智能控制提供了一条令人信服的前进之路。

研究团队目前正在扩展其模型,以便在现实世界场景中进行更大规模的测试。他们的长期愿景是将这一人工智能框架集成到城市运营系统中,为城市提供动力、管理交通并协调自动驾驶车队,从而使智能基础设施的愿景更接近现实。

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。